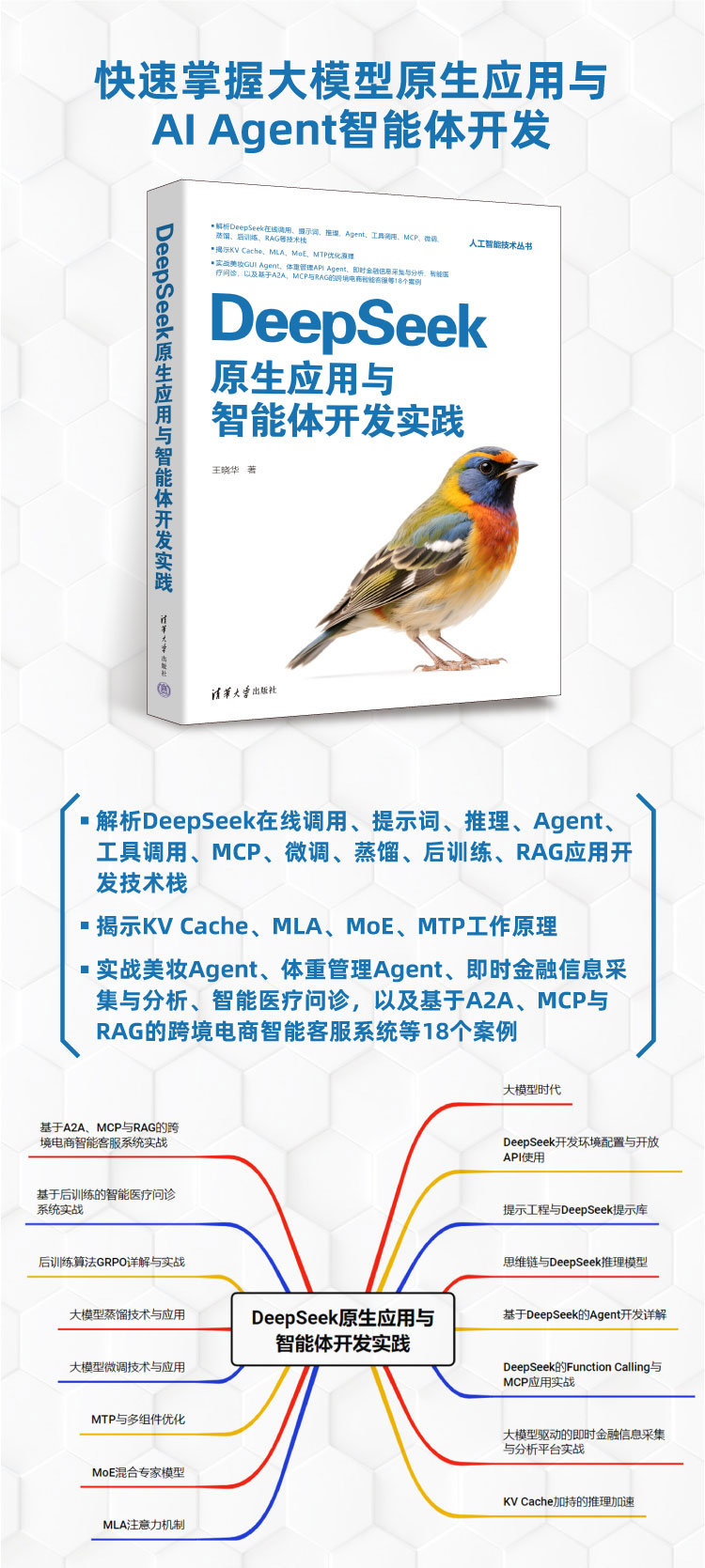

《DeepSeek原生应用与智能体开发实践》立足于国产大模型DeepSeek的技术生态,系统性地阐述了从基础原理到工程落地的完整知识体系,旨在培养开发者的大模型原生应用与智能体开发能力。在大模型技术快速迭代的当下,该书以国产模型为核心,避免了技术依赖的局限性,为国内开发者提供了一套完整的技术栈指南。

全书内容共分十六章,以技术演进和工程实践为主线展开。

开篇从大模型时代背景切入,回顾了大语言模型的发展简史与核心概念,解析了注意力机制等里程碑技术,并探讨了模型生成策略与Scaling Law等基础理论,为读者建立宏观认知。随后进入实战准备阶段,详细介绍DeepSeek开发环境的配置方法与开放API的使用技巧,这是进行后续开发工作的基础保障。在此基础上,作者深入探讨了提示工程的核心原理,结合DeepSeek特有的提示库功能,讲解如何通过精准的提示设计激发模型能力。思维链技术的引入则进一步强化了模型的推理能力,使读者能够理解并运用DeepSeek在复杂逻辑推理任务中的优势。

进入核心开发环节,作者系统讲解了基于DeepSeek的Agent开发全流程。书中不仅阐述了智能体的基础架构设计,还深入剖析了Function Calling机制与MCP(Model Context Protocol)的应用实战,使开发者能够构建具备工具调用能力的智能系统。为提升开发效率,书中专门介绍了大模型驱动的即时金融信息采集与分析平台这一典型案例,通过Crawl4AI爬虫框架与DeepSeek信息抽取能力的结合,演示了从数据获取到智能分析的全链条开发过程。在性能优化层面,作者通过代码级详解与量化实验对比,揭示了KV Cache缓存加速、MLA(Multi-head Latent Attention)注意力机制、MoE(Mixture of Experts)专家模型、MTP(Multi-Token Prediction)多词元预测等DeepSeek核心技术,将前沿算法转化为可复现的工程能力。

在模型定制与优化部分,书中涵盖了当前大模型领域的关键技术路径。大模型微调技术与应用章节提供了SFT等经典方法的实践指导,蒸馏技术章节则讲解了模型压缩与知识迁移的实现方式。特别值得一提的是,书中独家解析了后训练算法GRPO(Generalized Reward Policy Optimization)的原理与实战,通过智能医疗问诊案例展示了如何利用强化学习优化模型行为,设计奖励函数提升诊断准确性。全书最后落脚于综合性实战项目——基于A2A(Agent2Agent)架构的多Agent跨境电商智能客服系统,该系统集成RAG知识注入与MCP工具调度,覆盖多语种问答到商品推荐的商业闭环,体现了多智能体协作的先进理念。

作者以大模型技术演进为脉络,从Transformers核心机制切入,深度拆解DeepSeek原创技术,延伸至后训练算法与行业落地,构建了“基础理论-核心技术-工程实践”的完整知识图谱。这种层层递进的结构避免了知识碎片化,帮助读者建立全局性技术视野。

硬核代码与量化实验驱动是本书区别于纯理论著作的重要标志。核心章节均配套PyTorch实战代码,例如MLA注意力矩阵压缩、MTP多词元预测等复杂技术的实现细节都予以呈现,并通过显存占用、推理速度等量化对比实验直观展示优化效果,使开发者真正理解技术价值。

垂直行业场景深度赋能是本书的实践特色。书中聚焦金融、医疗、电商三大高价值领域,提供美妆Agent、体重管理Agent、金融信息采集、智能医疗问诊、跨境电商客服等至少十八个实战案例,突破了技术科普的局限,展现了AI技术解决实际问题的完整路径。

在配套资源方面,本书提供了完整的开发者支持体系,包括示例源码、数据文件、PPT课件、配图PDF以及读者微信交流群,形成了良好的学习生态。

王晓华,高校计算机专业讲师,长期致力于云计算、大数据与人工智能领域的研究与教学工作,拥有多年人工智能项目开发经验。除了本书之外,王晓华已在大模型与技术实践领域出版了多部著作,包括《DeepSeek大模型高性能核心技术与多模态融合开发》《ChatGLM3大模型本地化部署、应用开发与微调》《从零开始大模型开发与微调:基于PyTorch与ChatGLM》《PyTorch深度学习与计算机视觉实践》等,形成了覆盖大模型开发全链条的著作体系。此外,他还撰写了《深入探索Mamba模型架构与应用》《PyTorch语音识别实战》等专业技术书籍,以及《TensorFlow深度学习应用实践》《OpenCV+TensorFlow深度学习与计算机视觉实战》等深度学习经典教程,累计出版技术专著十余部,展现了其在AI技术传播领域的持续深耕。

点击查看馆藏资源